De meeste camera’s hebben tegenwoordig de techniek van de beweegbare beeldsensor ingebouwd. Deze bewegingen, vaak vijf-assig bieden de mogelijkheid van beeldstabilisatie, sensor oppervlak reiniging en inderdaad ook nog de optie van pixels shift of multishot. Omdat in het laatste geval acht beelden worden samengevoegd tot een beeld, waarbij elk afzonderlijk beeld over een minuscule afstand verschoven is (meestal een of een halve pixel) groeit het totale aantal pixels behoorlijk. Het idee van pixel shift komt van de video camera, die toentertijd met afzonderlijke slechts voor een kleur gevoelige beeldsensoren werkte. Elke sensor had slechts een beperkt aantal pixels (rond de een miljoen) en de techniek werkte zo dat het beeld werd opgebouwd uit e combinatie van elke sensor afzonderlijk. Om de bescheiden resolutie te verhogen werden er trucjes uitgehaald zoals het verschuiven van een sensor over een beperkte afstand, waarmee de kleurinterpretatie kon worden verbeterd en de ruis kon worden onderdrukt.

In digitale foto camera’s wordt gebruikt gemaakt van een enkele beeldsensor die met het bekende RGB Bayer patroon is overdekt. Hierdoor gaat per pixel nogal wat kleurinformatie verloren die door interpolatie wordt aangevuld.

De pixel shift technologie werkt als volgt: tijdens de opname wordt de beeldsensor over de afstand van een pixel verschoven, zodat elke pixel door alle RGB filters wordt belicht en daarmee alle kleurinfo kan opnemen. Omdat elke pixel ook meer licht kan opnemen wordt ook de ruis gereduceerd.

Nadeel is dat deze techniek alleen werkt met statief en met echt stationaire objecten.

Tot zover de theorie. Maar werkt het ook?

Ik heb geen Pentax of Sony of Panasonic of Leica (de SL2 is te duur, lomp en zwaar). Ik heb wel een Olympus Pen-F die een vergelijkbare techniek aanbiedt.

Voor alle duidelijkheid: in geen van de genoemde camera’s wordt de oppervlak van de photosites op de beeldsensor veranderd. Het fysieke oplossend vermogen blijft dus gelijk, ook als je de sensor beweegt en het aantal pixels softwarematig vergroot.

De Pen-F heeft een MFT formaat beeldsensor met 5184 x 3888 photosites. De lengte van een photosite (meestal ook als pixel aangeduid) is 17,4 mm / 5184 beeldpunten = 3.4 micrometer voor een totaal oppervlak van 226, 2 mm^ 2. Het oppervak per beeldpunt is 11,56 mm^2.

Het aantal effectieve beeldpunten is 20, 3 Megapixel. Ter vergelijk, de nieuwe Leica SL2 heeft een oppervlak per beeldpunt van 18,49 mm^2 bij een totaal effectief oppervlak van de beeldsensor van 46,7 Megapixel. Omdat een pixel dimensie-loos is (in tegenstelling tot de fysieke photosite), is het werkelijke oppervlak minder belangrijk. Het totale aantal megapixels wordt bij de multishot techniek van de SL2 vergroot tot 187 Megapixel. (= 46,7 x 4).

Bij de Olympus Pen-F zijn de getallen wat bescheidener. De originele 20,3 Megapixel wordt vergroot tot 50 Megapixel. De originele maten (5184 x 3888) worden in Raw formaat vergroot to 10368 x 7776, een verdubbeling dus. Waar de leica SL2 dus een pixel verschuiving heeft van een halve pixel, is dit voor de Pen-F maar een kwart pixel.

Om de theoretische toename in scheidend vermogen te controleren, heb ik met de Pen-F de volgende studie uitgevoerd. Ik heb een super scherpe dia van het USAF test patroon genomen (van Image Engineering), de Kaiser belichtingseenheid en als objectief de 60 mm macro van Olympus, gediafragmeerd op f/8. Uiteraard op statief en enkele opnames gemaakt met de normale en enkele met de High Res stand.

De beelden zijn met Photoshop geopend en niet bewerkt. Er is geen enkel verschil in beeldkwaliteit waarneembaar.

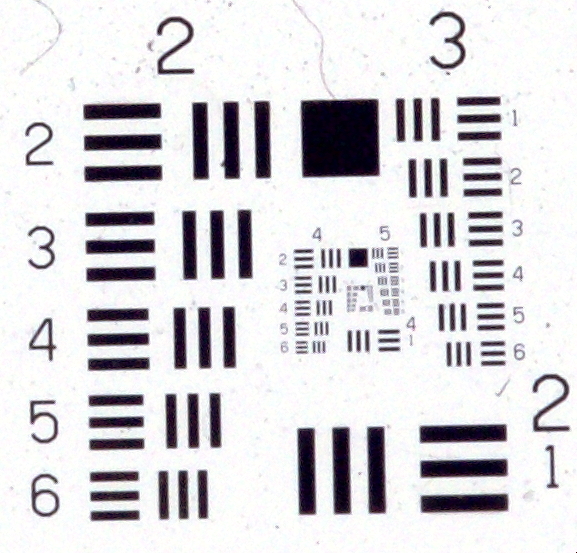

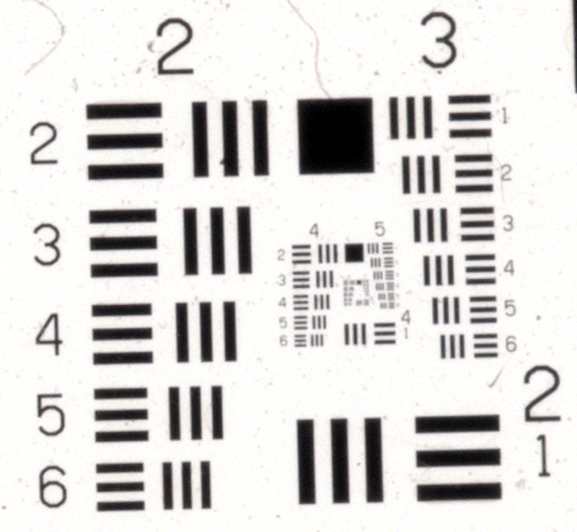

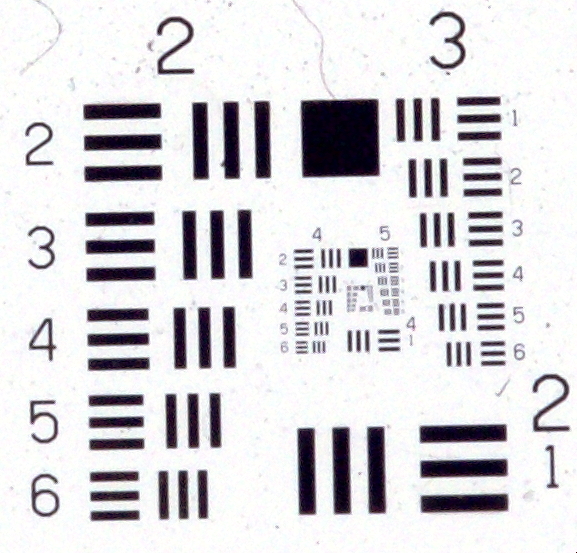

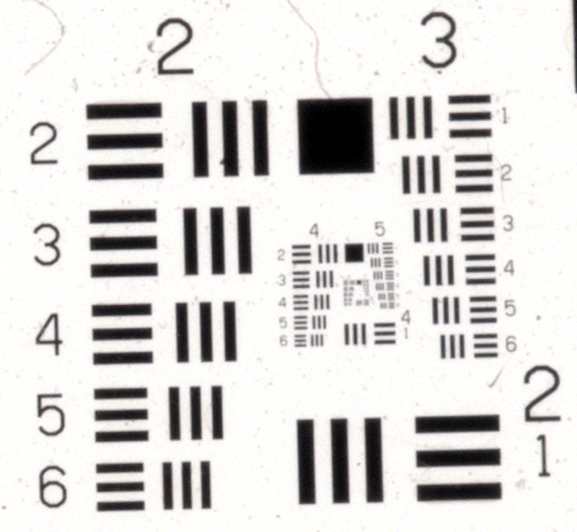

Zie hieronder de originele opname,

onder de High Res opname.

De laatste opname is tweemaal groter dan de originele. Om redenen van vergelijking is de HR opname dus tweemaal verkleind. Ook de werkelijke grootte laat geen verschil zien bij de fijnste patronen.

Ik heb geen ervaring met andere camera’s. Als die op vergelijkbare wijze werken als de Olympus, zal het verschil dus wel minimaal zijn. Zo wie zo is de hedendaagse fixatie op aantallen pixels erg overdreven. Je mag wel spreken van een hype. De fijnere details komen er alleen uit bij bewegingloze opnames (camera en object). Of met studio flits! Als je uit de hand werkt, zakt de feitelijke resolutie aanzienlijk

, al zal dit met beeldstabilisatie wel weer meevallen.

Here is the English version

Most cameras nowadays have the technique of the movable image sensor built in. These movements, often five-axis, offer the possibility of image stabilization, sensor surface cleaning and indeed also the option of pixel shift or multishot. Because in the latter case eight images are merged into one image, where each individual image is shifted over a minuscule distance (usually one or a half pixel), the total number of pixels grows considerably. The idea of pixel shift comes from the video camera, which originally worked with separate image sensors that were only sensitive to one colour. Each sensor had only a limited number of pixels (around one million) and the technique was such that the image was made up of a combination of each sensor individually. In order to increase the modest resolution, tricks such as shifting these sensors over a limited distance were used to improve colour interpretation and suppress noise.

In digital photo cameras, a single image sensor is used that is covered with the well-known RGB Bayer pattern. As a result, quite a lot of colour information is lost per pixel, which is supplemented by interpolation.

The pixel shift technology works as follows: during the recording, the image sensor is shifted over the distance of a pixel, so that each pixel is exposed by all RGB filters and can therefore record all colour information. Because each pixel can also capture more light, the noise is also reduced.

The disadvantage is that this technique only works with a tripod and with real stationary objects.

So much for the theory. But does it also work?

I don't have a Pentax or Sony or Panasonic or Leica (the SL2 is too expensive, bulky and heavy). I do have an Olympus Pen-F that offers a similar technique.

For the sake of clarity: in none of the mentioned cameras is the physical area of the photosites on the image sensor changed. The physical resolution remains therefore the same, even if you move the sensor and increase the number of pixels by software. This interpolated resolution is software generated and thus virtual. Anything can happen here!

The Pen-F has an MFT size image sensor with 5184 x 3888 photosites. The length of a photosite (usually also referred to as a pixel) is 17.4 mm / 5184 pixels = 3.4 micrometers, which translates into a total area of 226, 2 mm^ 2. The surface area for a pixel is 11.56 mm^2.

The number of effective pixels is 20. 3 Megapixels. To compare, the new Leica SL2 has a surface area per pixel of 18.49 mm^2 at a total effective surface of the image sensor of 46.7 Megapixels. Because a pixel is dimensionless (as opposed to the physical photosite), the actual surface area is less important. The total number of megapixels is increased to 187 megapixels with the SL2's multishot technique. (= 46.7 x 4).

With the Olympus Pen-F the numbers are a bit more modest. The original 20.3 megapixel is enlarged to 50 Megapixel. The original sizes (5184 x 3888) are enlarged in Raw format to 10368 x 7776, a doubling. While the Leica SL2 has a pixel shift of half a pixel, for the Pen-F this is only a quarter of a pixel.

To check the theoretical increase in resolution, I did the following study with the Pen-F. I took a super sharp slide from the USAF test pattern (from Image Engineering), the Kaiser exposure unit and as an objective the Olympus 2.8/60 mm macro, with the aperture at f/8. Of course on a tripod. Some shots made with the normal and some with the High Res mode.

The images were opened with Photoshop and not edited. There is no difference in image quality.

The pictures are above: first the original recording. The High Res recording is below this one.

The last picture is twice as large as the original one. For reasons of comparison, the HR recording has been reduced twice. Also the actual size shows no difference in the finest patterns.

I have no experience with other cameras.. If they work in a similar way to the Olympus, the difference will be minimal, so today's fixation on numbers of pixels is very exaggerated. You can speak of a hype. The finer details only come out with motionless shots (camera and object). Or with studio flash! If you get out of hand, the actual resolution drops considerably, although with image stabilization this will not be too bad.